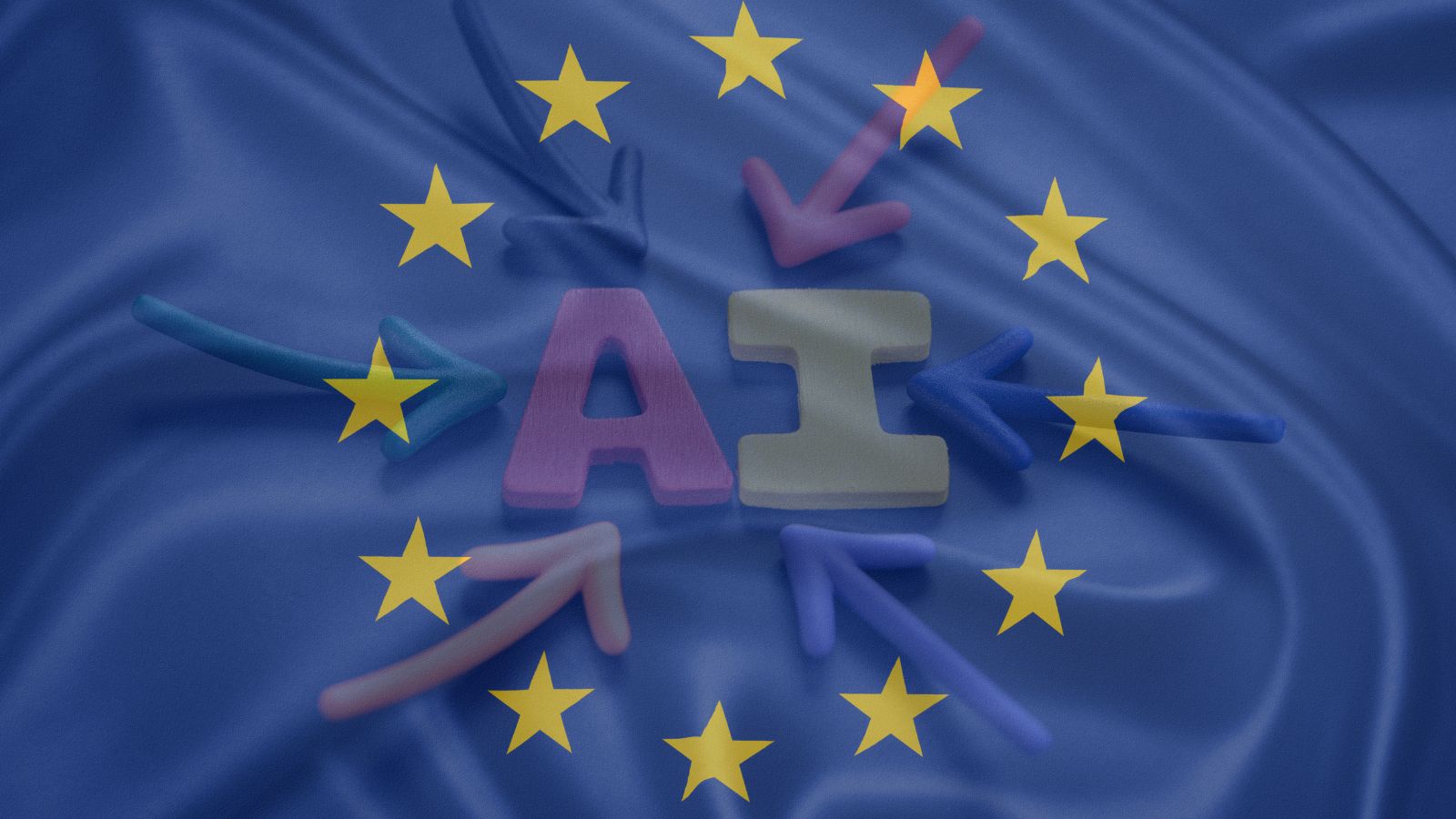

Il primo regolamento per l’intelligenza artificiale

È in questo contesto che emerge il primo grande regolamento a livello globale per l’intelligenza artificiale, l’AI Act europeo.

L’intelligenza artificiale è un’innovazione tecnologica che permea una vasta gamma di settori, rendendo la creazione di un quadro normativo un compito impegnativo. È essenziale stabilire regole chiare, richiesta avanzata anche dalle aziende del settore. L’AI Act europeo si concentra sui General Purpose AI (GPAI), modelli di intelligenza artificiale addestrati con enormi quantità di dati per fornire servizi in vari ambiti.

GPT di OpenAI e LaMDA di Google sono esempi di GPAI che possono essere utilizzati in diversi contesti. L’UE adotta una definizione ampia per includere il maggior numero possibile di modelli nel regolamento. Si distingue tra GPAI di base e quelli a rischio sistemico, con normative più rigorose per questi ultimi. La valutazione del rischio si basa su diversi fattori, inclusa la capacità computazionale espressa in FLOPS.

I GPAI di base devono garantire trasparenza, nominare un rappresentante per le autorità e stilare policy sul rispetto del copyright. Inoltre, devono fornire documentazione chiara sul funzionamento e l’addestramento del modello. Per i GPAI a rischio sistemico, oltre agli obblighi dei GPAI di base, è richiesta una comunicazione tempestiva alle autorità in caso di problemi gravi. Devono, inoltre, implementare piani di cybersicurezza e valutare i potenziali rischi prima del rilascio sul mercato.

L’AI Act affronta anche scenari specifici come i modelli open source, dove potrebbero mancare aziende dietro al progetto. Questa forma di regolamentazione dell’intelligenza artificiale rappresenta un primo passo significativo verso una regolamentazione più approfondita dell’AI, riflettendo la volontà di affrontare le sfide associate a questa tecnologia in rapida evoluzione.